java爬虫是一种使用java编程语言编写的软件,可自动从网络提取数据。java爬虫通常遵循以下步骤:发送http请求获取响应解析响应存储数据遵循链接常用的java爬虫库包括jsoup、httpclient和selenium。构建java爬虫需要创建项目、导入库、发送http请求、解析响应、提取数据和存储数据。

Java爬虫技术教程

什么是Java爬虫?

Java爬虫是一种使用Java编程语言编写的软件,它从网络上自动提取和解析数据。

为什么使用Java进行网络爬取?

立即学习“Java免费学习笔记(深入)”;

- 强大而灵活: Java是一门面向对象的语言,提供了适用于各种任务的广泛库和框架。

- 跨平台兼容性: Java编译的代码可以在大多数操作系统上运行,包括Windows、Linux和macOS。

- 健壮性: Java程序具有异常处理和垃圾回收功能,有助于确保可靠的操作。

Java爬虫如何运作?

Java爬虫通常遵循以下步骤:

- 发送HTTP请求: 爬虫使用HTTP协议向目标网站发送请求。

- 获取响应: 网站响应包含HTML或JSON等格式的数据。

- 解析响应: 爬虫使用解析器来提取所需的数据,例如文本、图像和链接。

- 存储数据: 提取的数据可以存储在数据库、文件系统或其他存储机制中。

- 遵循链接: 爬虫还可以遵循响应中发现的链接,以进一步探索网站。

常见的Java爬虫库

对于Java爬虫开发,有许多成熟的库可用:

- Jsoup: 一个流行的HTML解析器,用于从HTML文档中提取数据。

- HttpClient: 一个HTTP客户端库,用于发送和接收HTTP请求。

- Selenium: 一个用于自动化浏览器操作的框架,可用于动态网站的爬取。

如何构建一个Java爬虫?

构建一个Java爬虫需要以下步骤:

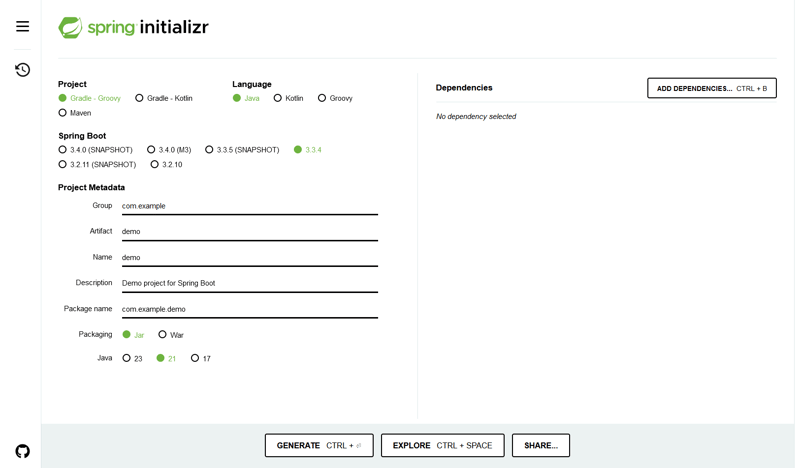

- 创建Java项目: 在IDE中创建一个新的Java项目。

- 导入库: 导入所需的爬虫库,例如Jsoup和HttpClient。

- 发送HTTP请求: 使用HttpClient发送HTTP请求到目标网站。

- 解析响应: 使用Jsoup解析响应的HTML内容。

- 提取数据: 从解析的HTML中提取所需的数据,例如文本或链接。

- 存储数据: 将提取的数据存储在数据库或其他存储机制中。

通过遵循这些步骤,你可以使用Java构建强大的爬虫来从网络上自动提取数据。

以上就是java爬虫技术教程的详细内容,更多请关注php中文网其它相关文章!

版权声明:本文内容由网友自发贡献,版权归原作者所有,本站不承担相应法律责任。如您发现有涉嫌抄袭侵权的内容,请联系 yyfuon@163.com