jsoup是一个易用的java html解析器,适用于爬取网站。它可以通过建立连接、解析html、提取数据、迭代元素和存储数据等步骤实现爬虫功能。示例代码展示了如何使用jsoup爬取网站标题。该教程还涵盖了处理ajax、解析css选择器、并行抓取、代理和验证码等进阶主题。

Java 爬虫 Jsoup 视频教程

一、简介

对于初学者来说,Jsoup 是一个方便易用的 Java HTML 解析器。它可以轻松地提取和解析 HTML 元素,非常适合爬取网站。本教程将指导您使用 Jsoup 构建一个简单的爬虫。

二、所需工具

立即学习“Java免费学习笔记(深入)”;

- Java 开发环境 (JDK 8 或更高版本)

- Jsoup 库 (jsoup.org)

- 文本编辑器或 IDE

三、步骤

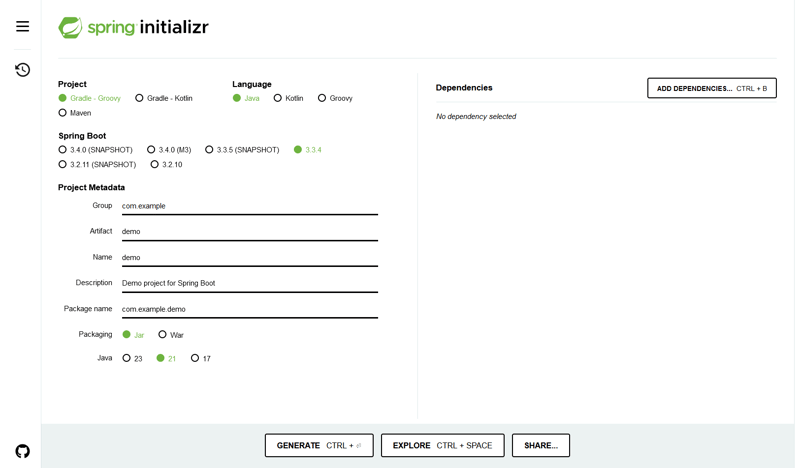

1. 创建项目

- 创建一个新项目并添加 Jsoup 库的依赖。

- 在 src 目录下创建一个 Java 类,如 MyCrawler.java。

2. 建立连接

- 创建一个 Connection 对象来建立与目标 URL 的连接。

- 使用 get() 方法获取页面内容。

3. 解析 HTML

- 使用 Jsoup.parse() 方法将页面内容解析为 Document 对象。

- Document 对象提供了对 HTML 元素的访问。

4. 提取数据

- 使用 select() 方法选择特定的 HTML 元素。

- 使用 text()、attr() 和其他方法提取所需数据。

5. 迭代元素

- 使用 forEach() 方法迭代元素集合。

- 根据需要提取和处理每个元素的数据。

6. 存储数据

- 可以将提取的数据存储到数据库、文件或其他数据结构中。

四、示例代码

以下是如何使用 Jsoup 爬取网站并提取标题的示例代码:

import org.jsoup.Jsoup;

import org.jsoup.nodes.Document;

import org.jsoup.nodes.Element;

public class MyCrawler {

public static void main(String[] args) {

try {

// 建立连接

Connection connection = Jsoup.connect("https://www.example.com");

Document document = connection.get();

// 提取标题

String title = document.title();

System.out.println(title);

} catch (IOException e) {

e.printStackTrace();

}

}

}

五、进阶主题

- 处理 AJAX 和 JavaScript

- 解析 CSS 选择器

- 并行抓取

- 使用代理和验证码

以上就是java爬虫jsoup视频教程的详细内容,更多请关注php中文网其它相关文章!

版权声明:本文内容由网友自发贡献,版权归原作者所有,本站不承担相应法律责任。如您发现有涉嫌抄袭侵权的内容,请联系 yyfuon@163.com